一、介绍

为了应对 TLS in TLS 和指纹识别等阻断或封禁的风险,Xray-core 团队推出了 VLESS Vision 和 VLESS Reality 两种新颖的技术方案。它们能够有效地隐藏和保护流量的特征,提高安全性和稳定性。如果您想了解更多详细信息,请点击 Vision 和 Reality 的查看。

| 协议组合 | 解决 TLS in TLS | 解决指纹问题 | 自带多路复用 | 是否支持CDN |

|---|---|---|---|---|

| VLESS-Vision-TLS | ✅ | ❌ | ❌ | ❌ |

| VLESS-Vision-uTLS-REALITY | ✅ | ✅ | ❌ | ❌ |

| VLESS-gRPC-uTLS-REALITY | ❌ | ✅ | ✅ | ❌ |

二、环境

- 一台没有被封禁的VPS,VPS选购指南。

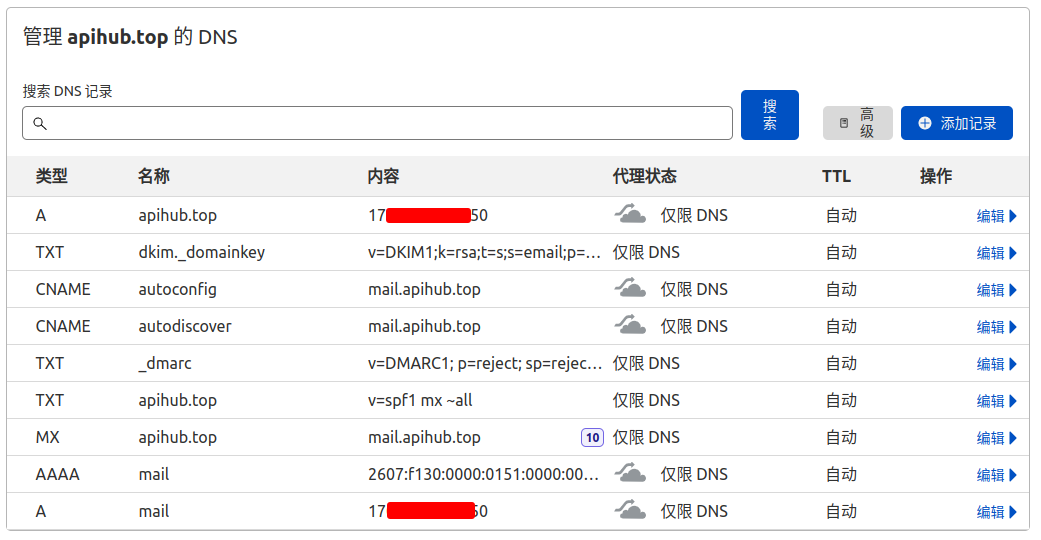

- 需要一个域名【非必须】

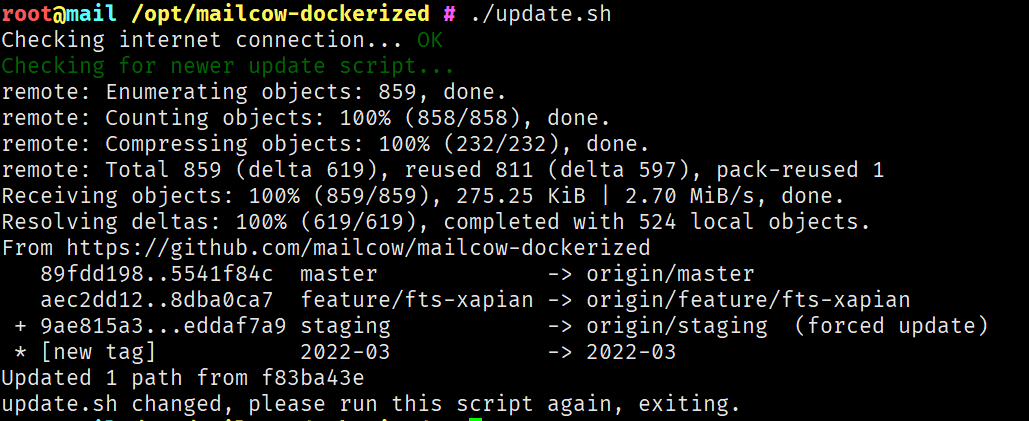

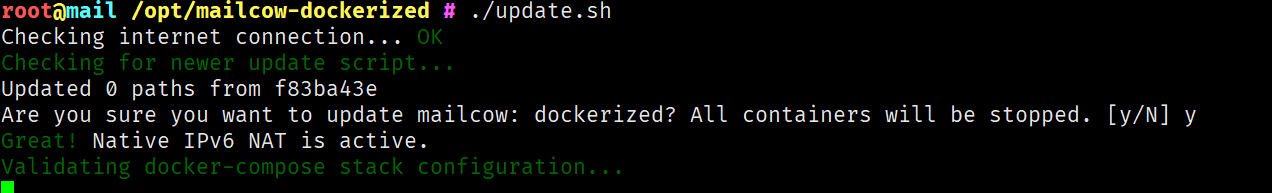

三、搭建步骤

1.ssh登录服务器(略)

2.下载脚本

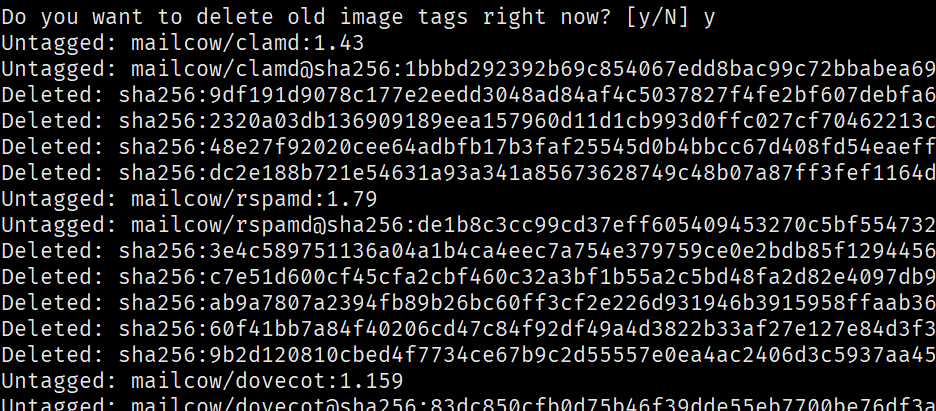

3.安装

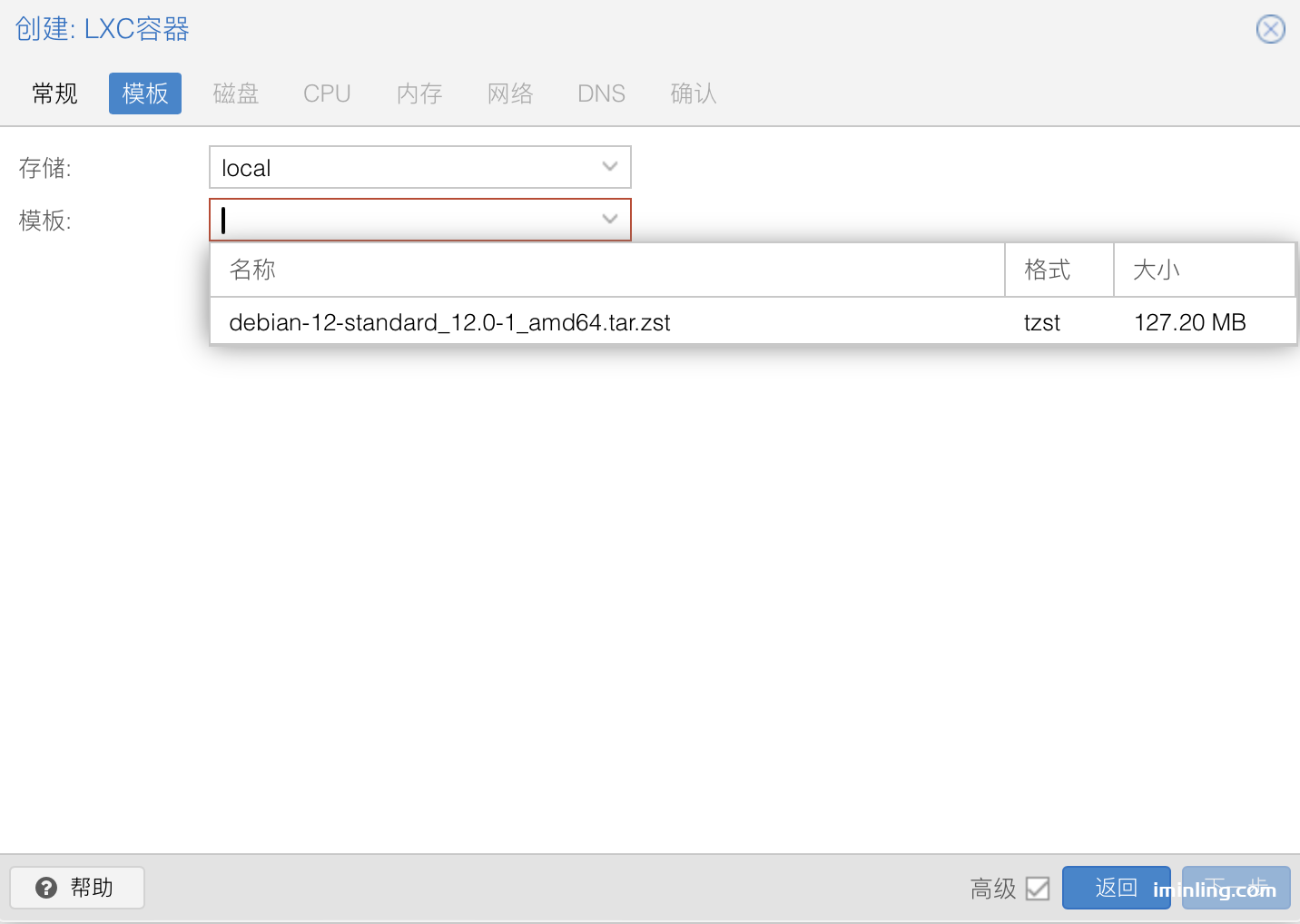

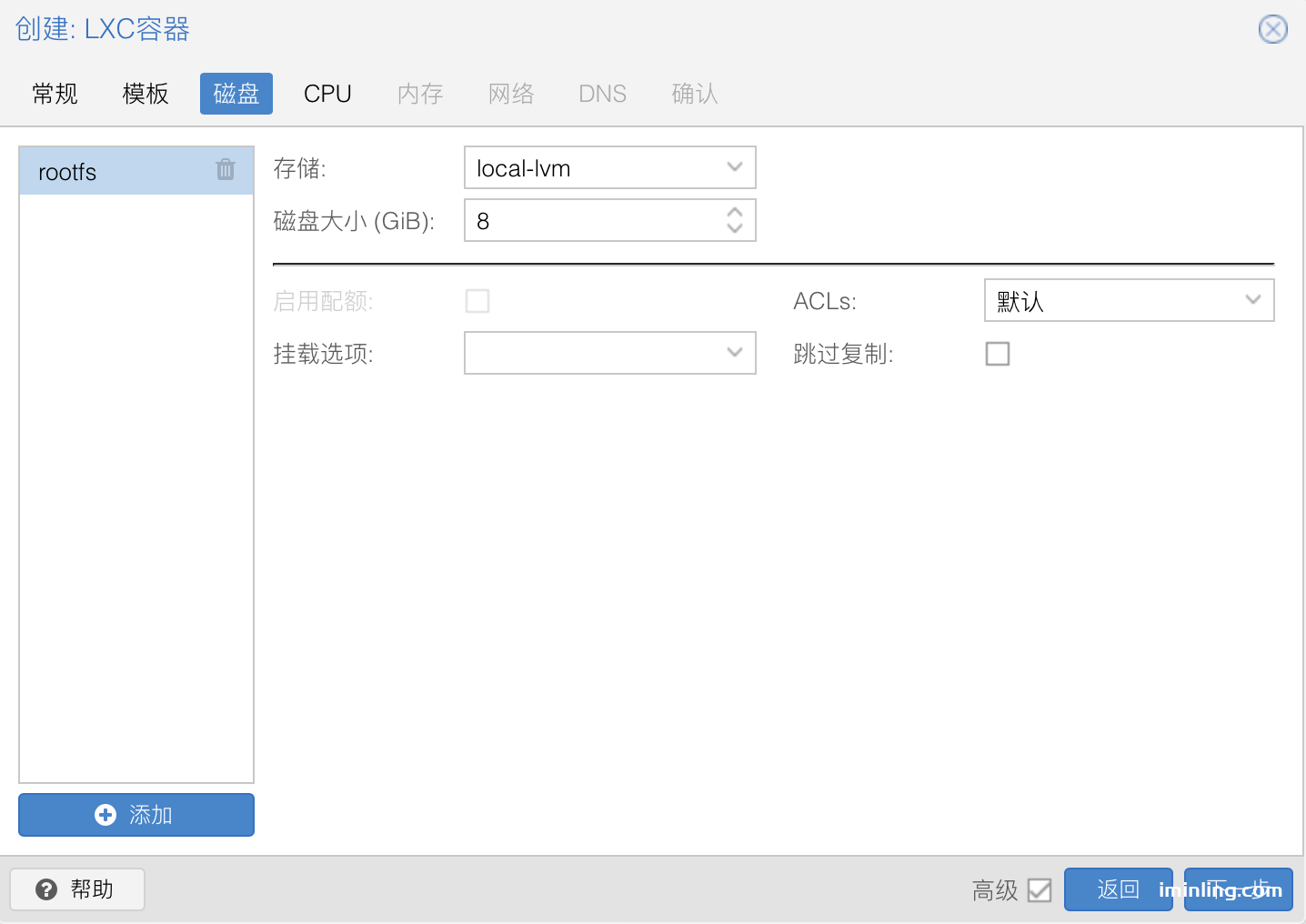

- 有两种安装方式,第一种需要自己购买域名,第二种无需购买域名。

- 如果没有域名,可以跳过第一种安装方式。

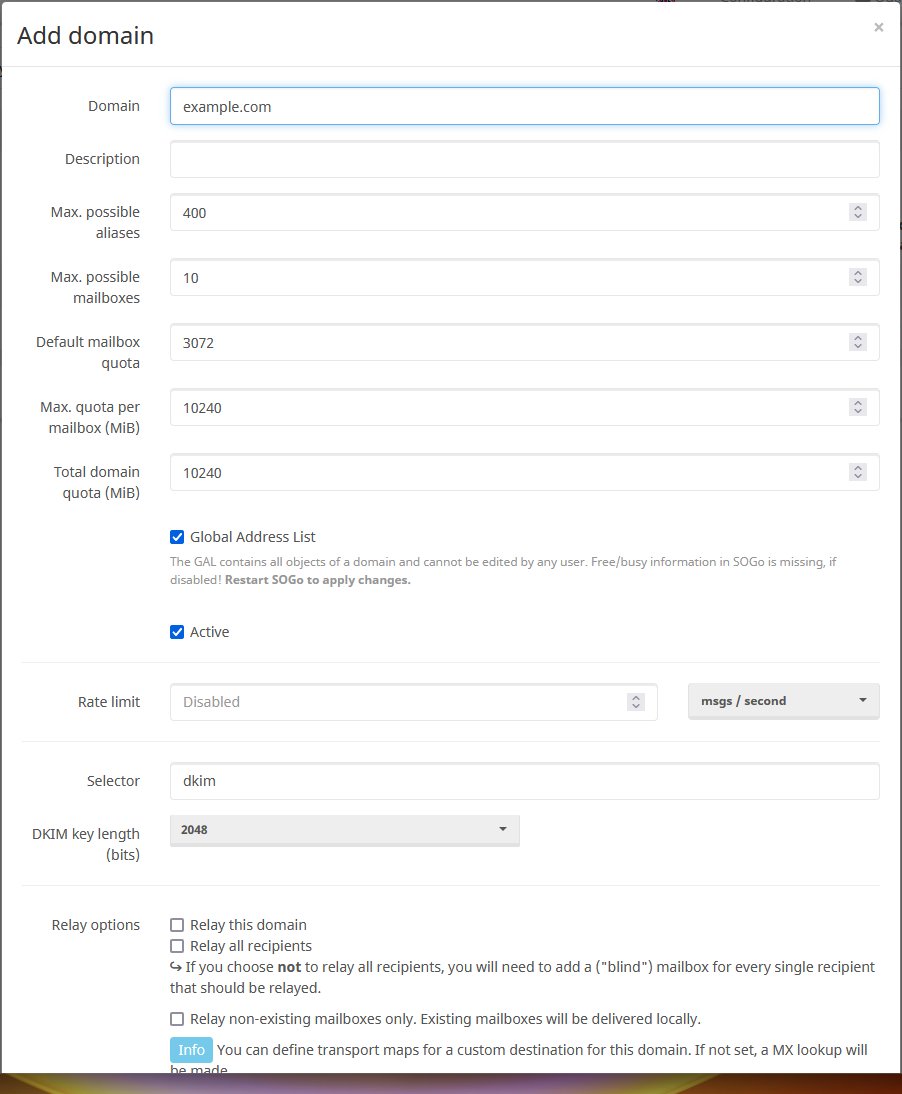

1.第一种安装方式(需要域名)

- 建议选择 2任意组合安装->选择0,7 ,这样的安装会同时安装 Vision_TLS、Reality+TCP+uTLS+Vision、Reality+gRPC+uTLS

- 路径:vasma->2->1->0,7

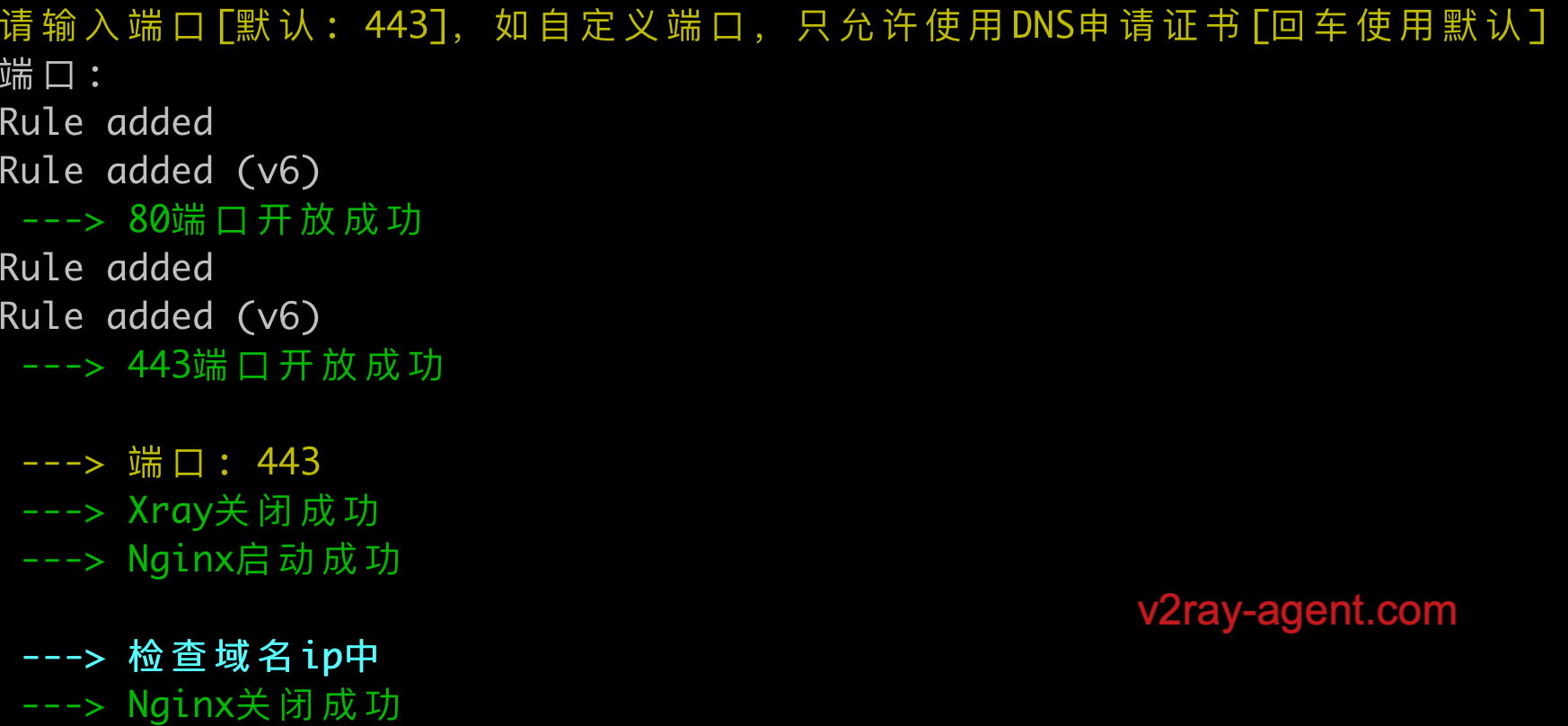

第一步,输入域名

第二步,端口默认443即可,也可以自定义端口安装

第三步,注意事项。

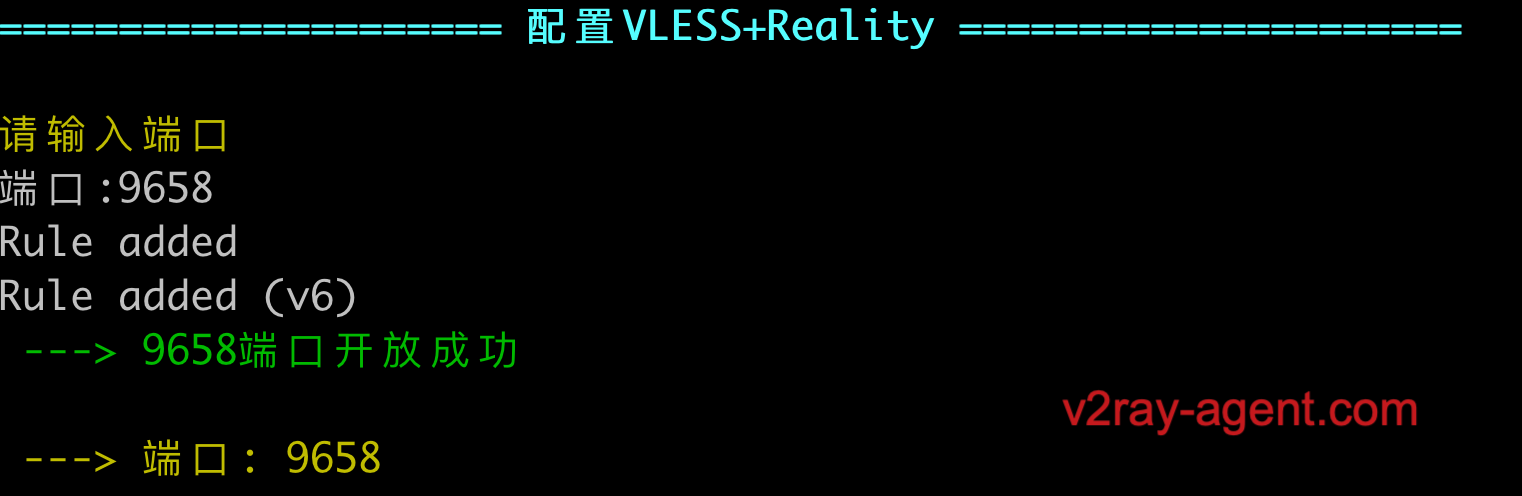

当配置VLESS+Reality 需要注意一下,这里的端口可以自定义,如果上方使用了自定义端口这里则可以输入 443 。

剩下的一直回车后会自动展示账号,到这里有域名的情况就搭建完成了。

2.第二种安装方式(无需域名)【推荐安装】

- 观看此教程

可参考的域名

四、客户端配置

手动配置示例

- VLESS Reality gRPC uTLS

- VLESS Reality TCP Vision uTLS

- VLESS TCP TLS Vision uTLS

3.iOS

1.V2BOX

- 支持Reality和Vision

- vasma->7.账号管理->2.查看订阅 拉取即可

- 客户端配置->Configs->右上角+号->Add Subscription

2.FoXray

- 支持Reality和Vision

- vasma->7.账号管理->2.查看订阅 拉取即可

- 客户端配置->订阅列表->右上角+号

3.Shadowrocket

- vasma->7.账号管理->2.查看订阅 拉取默认订阅即可

4.sing-box

- vasma->7.账号管理->2.查看订阅 拉取sing-box订阅即可

- Profiles->New Profiles->Type(Remote)->复制sing-box订阅链接到URL

4.Windows

1.v2rayN[需下载最新]

1.reality-tcp

2.reality-grpc

五、注意事项

1.Vision被封答疑【以下内容来源】

首先,如果你特别不想被封,请先选择一个干净的 IP,并按照 配置正确 去搭建、使用 XTLS Vision。

但是,即使你这样做了,也无法保证 100% 不被封。自去年底始,很多人的未知流量秒封 IP,TLS in TLS 流量隔天封端口。XTLS Vision 不是未知流量,且完整处理了 TLS in TLS 特征,目前看来效果显著。但这并不意味着,用 XTLS Vision 可以 100% 不被封,认识到这一点是非常、非常重要的,不要自己偶然被封就大惊小怪。

因为除了协议本身,还有很多角度能封你。以 IP 为例,你无法保证 IP 真的干净,无法避免被邻居波及,无法避免整个 IP 段被重点拉清单。也有可能某些地区的 GFW 有独特的标准,比如某个 IP 只有寥寥数人访问连却能跑那么多流量,封。如果你的 XTLS Vision 被封了,但没有出现去年底 TLS 那样的大规模被封报告,我真心建议你换端口、换 IP、换服务商依次试一遍。

排查

- 打开[ping.pe]

- 输入 IP 检测ping可用

- 输入 IP:Port 检查端口是否可用

- 主要是看最后几个是否为绿色

2.Reality不支持CDN

3.Reality工作原理

一些GitHub issues的零碎信息,完整版本可以等xray-core更新文档

4.Xray-core内存问题解答【以下内容来源】

Xray 占几百兆内存,并不代表这是最低要求,而是正是因为你有空闲的内存,Xray 才会拿来当缓存、备用,因为不用白不用。

仅此而已,内存完全够用的情况下,却非要追求这个数据的好看,想捂着不让 Xray 用,有什么意义呢?VPS 商家给你退钱?

对于 Xray 这样的代理类软件,内存占用大头在于对被代理数据的缓存,能用的内存多就能多缓存一些数据,麻烦搞清楚状况。

换句话说,内存占用大头取决于你要的缓存数据能力,每个代理软件的默认策略不一样,你调低缓存自然就可以实现数据的好看

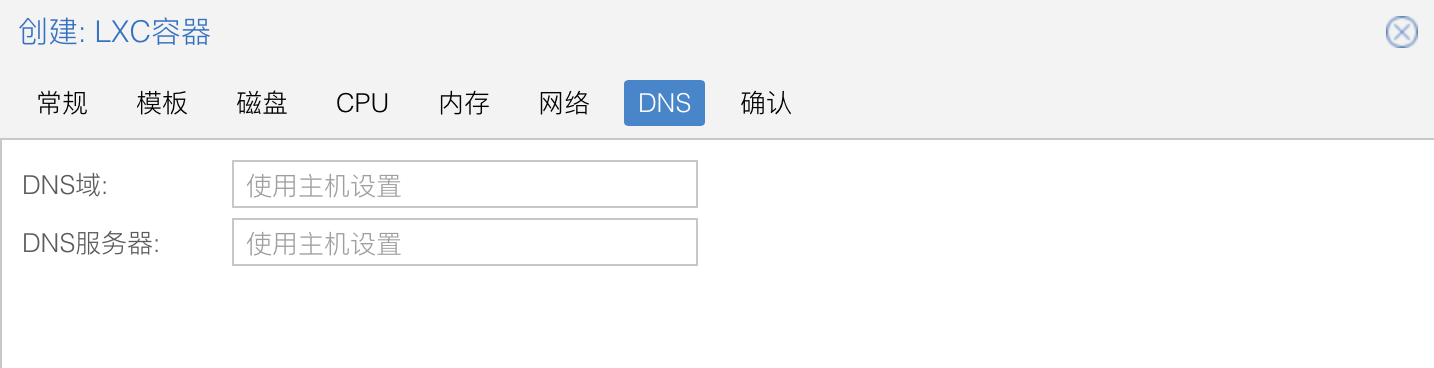

5.影响Reality使用体验的几个因素【以下内容来源】

目标网站/域名的选择会极大程度地影响 REALITY 代理的延迟、速度、稳定性等:

- 至少目前,REALITY 每次都要去拿握手包,需要注意目标网站近不近、稳不稳定(请求多了就把你半拉黑也是一种不稳定)。

- 运营商层面可能会给某些域名更高的流量优先级,拥堵时优先保证它们的流量通过。

- GFW 层面至少有黑名单(google)和白名单(microsoft),可能还有其它名单,比如偶尔干扰/限速名单(github?)

如果出现今天不可用但是昨天可用的情况,可能出现的原因:

也可能是你们天天逮着 microsoft、apple 之类的偷,GFW 开始测试了,有人说伊朗那边就有运营商在“内测” yahoo 的 IP 白名单。

REALITY 以后会出个缓存模式,提前采集目标网站的特征,就不用每次都去拿了,这也是相对于 ShadowTLS 之类的优势之一。

还有就是 REALITY 隐藏玩法的任意 SNI、无 SNI,对 REALITY 来说,只要服务端 serverNames 写了,客户端 serverName 就能填。

我需要说明一下不是只有 1.1.1.1 和 8.8.8.8,而是绝大多数网站都有“默认证书”。不过不希望这个玩法泛滥,因为特征明显。

6.v1.8.1 增强版 XUDP 的 Global ID & UoT Migration 有什么效果【以下内容来源】

v1.8.1 以前,你用任何 UoT,假设服务端用 A 端口与多目标通信,若 TCP 断了,比如切换网络,重连后服务端会改用 B 端口。 v1.8.1 开始,你用 VLESS(包括 Mux.Cool),即使 TCP 断了,重连后服务端还是会用 A 端口。

尤其是,对 P2P 有奇效。从某种程度上来说,这才是真正的 FullCone。双端 Xray-core v1.8.1+ 自动启用,无需额外配置。

可以用 NatTypeTester,先连接家里 WiFi 测一下,再连接手机热点(流量)测一下,你会发现服务端出口端口没变,挺神奇的。

7.Trojan是否可以平替VLESS答疑【以下内容来源】

都是 TLS,但怎么用 TLS,是有讲究的,有句话我早就想对鼓吹 Trojan 平替 VLESS 的人说:真以为 Trojan 能用一辈子? 早在三年前的 VLESS BETA 我就给你们说过,光套一层加密并不能掩盖里面的时序特征,所以 VLESS 有 flow 机制。 但是呢,以前的 GFW 没上手段,简单套个 TLS 在实践上的确还可以用,就像 WSS ALPN 一直很明显,但以前它能用。 它们还能用,我就没必要提前出牌,等 GFW 上了手段,我再继续出牌,并且不推荐大家再用旧的 WS、无 flow 等。

有一点需要再次强调,我支持的始终是 TLS 上的百花齐放,而不是 TCP 上的,原因以前说过很多,可以去 v2ray 翻翻。 前段时间不是有个论文嘛,算了不想说了,有空时再评论。 #14

8.各协议 2023 现状【以下内容来源】

还是简单说一下各协议 2023 现状(对于中国大多数地区)

- SS 全随机数类秒封 IP;IPv6 不一定封,

因人品而异;绕过“省钱规则”曾经不封,目前不知道,但若流行了肯定会封,参考 SSR - Trojan、WSS 隔天封端口;Cloudflare 不封但干扰会很严重,因地区而异

- 黑名单是单连接 TLS in TLS 握手典型特征,因为用强 padding(Vision)或开 mux 就能绕过,注意不要让猪队友客户端连接

- REALITY 类偷白名单域名的话即使有上述特征也不封;甲骨文等太黑的 IP 段偷大厂/偷别人不一定连得上

- Hysteria、TUIC 不一定封,因配置、地区而异;可能会遇到 QoS 限速,因运营商而异;总之就是使用体验严重因人而异

所以你可以看到以前的流行协议在今年是什么样的存活状况,事实上今年自建的大都是新协议,非 IPLC 中转用的协议原理也没差 你的主观印象中“今年能连接国外网络的人数并没有减少”,严格来说就是因为自建,一些人把它透明化了,卖中转给机场和个人 #15